كلمة شكر

قبل أن أدخل في هذه التدوينة، أود أن أبدأ بشكر فريقي الرائع. كانت هذه آخر ورقة بحثية نناقشها سويًا، بعد سلسلة طويلة من الأسئلة الصعبة والتجارب التي لم نكتفِ فيها بأن تكون النتائج صحيحة، بل أردنا أن نفهم كيف ولماذا يتعلم النموذج. كانت مدارسة ورقة ممتعة مع كم كبير من الحماسة لا أعلم سببها هل لأنها آخر ورقة أم لأن قائد المدارسة أبدع في إدارة النقاش.

هذا النص ليس تلخيصًا لورقة بحثية، بل محاولة لشرحها من داخل تجربة حقيقية كشفت لنا حدود بعض افتراضاتنا.

المقدمة: عندما تفشل دالة المكافأة في تمثيل ما نريد تعلّمه

في التعلم المعزز (Reinforcement Learning)، لا يتعلّم النموذج “المهمة” كما نفهمها نحن، بل يتعلّم تعظيم دالة المكافأة كما صُمِّمت له. هذه حقيقة بديهية نظريًا، لكنها كثيرًا ما تُهمل عمليًا، خصوصًا عند الانتقال من هدف واحد إلى تعدد الأهداف (Multi-objective Reinforcement Learning).

لنفترض نموذجًا بسيطًا للتعلم المعزز، حيث نبحث عن سياسة π تعظّم القيمة المتوقعة التالية:

$$\pi^* = \arg\max_{\pi} ; \mathbb{E}_{\tau \sim \pi} \left[ R(\tau) \right]$$

في أبسط الحالات، تكون دالة المكافأة R(τ) كمية عددية واحدة، تمثل “جودة” المسار τ. لكن في نماذج اللغة الحديثة — وخاصة في نماذج الاستدلال — نادرًا ما يكون الهدف وحيدًا.

بدلًا من ذلك، نتعامل مع مجموعة من المكافآت:

$$R(\tau) = { r_1(\tau), r_2(\tau), \dots, r_K(\tau) }$$

حيث قد تمثل هذه المكافآت:

- صحة النتيجة

- جودة الاستدلال

- الالتزام بالتنسيق

- السلامة

- الكفاءة

وهنا يظهر السؤال الجوهري: كيف نحوّل هذا المتجه من الأهداف إلى إشارة واحدة يمكن استخدامها لتحديث السياسة؟

الاختزال إلى رقم واحد: افتراض غير بريء

الممارسة الشائعة هي تحويل مجموعة المكافآت إلى قيمة عددية واحدة عبر عملية تجميع (Aggregation)، مثل:

$$r_{\text{sum}}(\tau) = \sum_{k=1}^{K} w_k , r_k(\tau)$$

ثم استخدام هذه القيمة في حساب الـ advantage، ومن ثم تحديث السياسة.

رياضيًا، هذا الاختزال يبدو مبررًا: نحن نُسقِط متجهًا في ℝ^K إلى عدد في ℝ. لكن هذا الإسقاط يحمل افتراضًا قويًا غالبًا ما لا نصرّح به:

أن جميع التركيبات المختلفة للأهداف يمكن ترتيبها خطيًا على محور واحد دون فقدان للمعلومة المهمة.

وهذا الافتراض غير صحيح في كثير من الحالات، خصوصًا عندما:

- تختلف طبيعة المكافآت (ثنائية، مستمرة، نادرة)

- تختلف صعوبة تحقيقها

- أو تكون الأهداف متعارضة ضمنيًا على مستوى السلوك

فقدان قابلية التمييز (Loss of Identifiability)

لفهم المشكلة بدقة، لننظر إلى حالتين مختلفتين سلوكيًا:

$$\mathbf{r}^{(1)} = (1, 0) \quad\text{و}\quad \mathbf{r}^{(2)} = (0, 1)$$

إذا كان الوزن متساويًا، فإن: $$r_{\text{sum}}^{(1)} = r_{\text{sum}}^{(2)} = 1$$

بعد التطبيع داخل المجموعة، قد يحصل المساران على نفس قيمة الـ advantage، رغم أن:

- الحالة الأولى تمثل نجاحًا في الهدف الأول فقط

- الحالة الثانية تمثل نجاحًا في الهدف الثاني فقط

ومن وجهة نظر خوارزمية التحسين:

هاتان الحالتان متكافئتان.

وهنا تحديدًا نفقد ما يسمى قابلية التمييز بين الأسباب السلوكية للنجاح أو الفشل. لا يعود النموذج قادرًا على معرفة لماذا كوفئ، بل فقط أنه كوفئ.

الإلغاء (Cancellation) بوصفه ظاهرة هندسية

ما يحدث هنا ليس مجرد ضجيج إحصائي، بل ظاهرة هندسية حقيقية:

نحن نحول فضاء مكافآت متعدد الأبعاد إلى بعد واحد، ثم نستخدم هذا البعد الواحد لتوجيه التعلّم. هذا الإسقاط يؤدي إلى:

- تساوي حالات مختلفة منطقيًا

- إلغاء إشارات جزئية مهمة

- تشجيع سياسات مختصرة (Shortcut Policies)

خصوصًا عندما يكون أحد الأهداف أسهل تحقيقًا من غيره، أو لا يتطلب حسابًا داخليًا معقدًا (مثل الوصول السريع إلى النتيجة دون استدلال).

Group Policy Optimization (GRPO) ومشكلة التطبيع الجماعي

في أساليب Group Policy Optimization (GPO / GRPO)، يتم توليد مجموعة من المسارات {τ₁, …, τG} للسؤال نفسه، ثم حساب الـ advantage عبر تطبيع المكافأة داخل المجموعة:

$$A_i = \frac{r_{\text{sum}}(\tau_i) - \mu(r_{\text{sum}})}{\sigma(r_{\text{sum}})}$$

حيث تُحسب μ و σ على مستوى المجموعة.

هذا الإجراء يهدف إلى تقليل التباين، وهو فعال عندما تكون المكافأة أحادية الهدف. لكن عند تعدد المكافآت، يظهر خلل بنيوي:

التجميع يحدث قبل التطبيع.

أي أننا نطبّع مجموع المكافآت، لا المكافآت نفسها. نحن نطبّع النتيجة النهائية، لا المكونات التي أدت إليها.

التجربة الواقعية: عندما تكون النتيجة صحيحة لكن التعلم خاطئ

كيف يمكن لنموذج أن يعطي حكمًا صحيحًا، وفي الوقت نفسه يكون تعلّمه خاطئًا؟

هذا السؤال لم يأتِ من فراغ، بل من تجربة عملية:

- النتيجة النهائية صحيحة

- التصنيف دقيق

- التنسيق مضبوط

ومع ذلك، كان هناك شيء مكسور: الاستدلال لم يعد جزءًا من السلوك. النموذج لم يكن يفكّر، بل يصل إلى الإجابة بأقصر طريق ممكن.

متى بدأ الخلل؟

في تدريبنا، طلبنا من النموذج ثلاثة أشياء في آن واحد:

- أن تكون النتيجة صحيحة

- أن يكون الاستدلال مختصرًا

- أن يلتزم بتنسيق محدد

ظاهريًا، هذه أهداف معقولة. لكن عمليًا، الجمع بينها خلق حافزًا غير مقصود:

إذا كانت الإجابة الصحيحة تمنحني المكافأة الكاملة، فلماذا أستثمر في الاستدلال؟

وهنا لم يفشل النموذج، بل نجح في تحسين دالة المكافأة كما عرّفناها. هذا هو الدرس الأول: النماذج تتعلم ما نكافئه، ليس ما نريده.

لماذا لا يظهر هذا الخلل في المقاييس؟

لأن المقاييس النهائية تقيس النتيجة، لا المسار. والتعلم المعزز، بطبيعته، لا يهتم بالنية، بل بالإشارة التي تصله. حين تكون الإشارة واحدة، لا يهمه كيف وصل إليها.

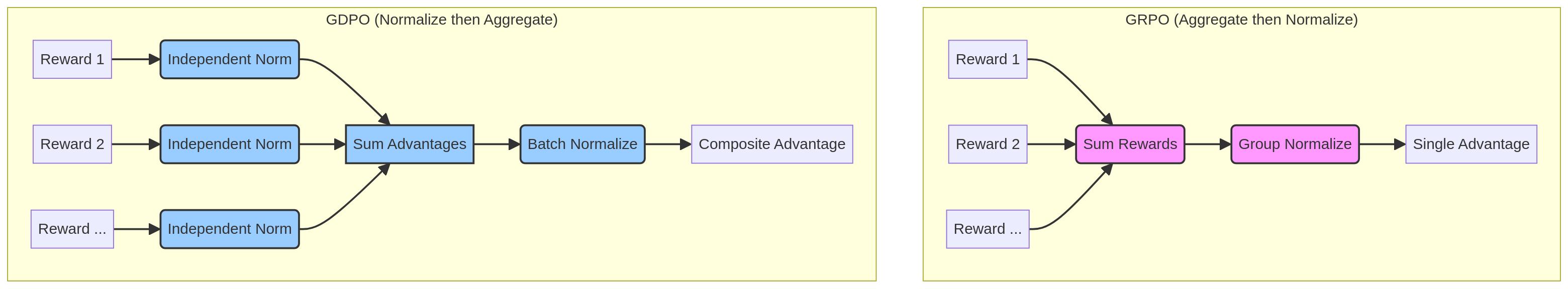

فكرة GDPO: تطبيع قبل التجميع

تأتي GDPO (Group reward–Decoupled Normalization Policy Optimization) لتعيد ترتيب هذه العملية ترتيبًا منطقيًا.

بدلًا من: $$r_{\text{sum}} \rightarrow \text{normalize}$$

تقترح GDPO: $$r_k \rightarrow \text{normalize independently} ;;\forall k$$

أي: $$A_k(\tau_i) = \frac{r_k(\tau_i) - \mu(r_k)}{\sigma(r_k)}$$

ثم يتم تجميع الـ advantages: $$A_{\text{sum}}(\tau_i) = \sum_{k=1}^{K} w_k , A_k(\tau_i)$$

وأخيرًا، يُجرى تطبيع على مستوى الدفعة (batch-wise) لضبط مقياس التحديث:

$$A_{\text{final}}(\tau_i) = \frac{A_{\text{sum}}(\tau_i) - \mu(A_{\text{sum}})}{\sigma(A_{\text{sum}})}$$

بهذا الترتيب:

- يحتفظ كل هدف بإشارته الخاصة

- لا تُلغى الإشارات قبل أن تُفهم

- ويصبح التحديث أكثر قابلية للتفسير والتوجيه

من الرياضيات إلى السلوك

هذا التعديل يبدو بسيطًا رياضيًا، لكنه يحمل أثرًا سلوكيًا عميقًا:

- النموذج لا يعود يرى “نجاحًا عامًا”

- بل يرى في أي هدف نجح، وفي أي هدف أخفق

وهذا الفرق هو ما يحدد ما إذا كان النموذج سيتعلّم:

- التفكير

- أم تجاوزه

من هنا تبدأ القصة الحقيقية للورقة… ومن هنا أيضًا بدأت تجربتنا.

ماذا يعني ذلك عمليًا؟

يعني أن حالات مختلفة سلوكيًا:

- إجابة صحيحة بلا استدلال

- إجابة صحيحة مع استدلال متماسك

قد تتحول إلى نفس القيمة العددية بعد الجمع والتطبيع في GRPO. ومن وجهة نظر النموذج: هاتان الحالتان متساويتان.

النتيجة الطبيعية؟ يختار الأرخص حسابيًا: الإجابة بلا تفكير.

هذه ليست ضوضاء… بل فقدان اتجاه

هذا ما أسميناه في نقاشنا “إلغاء الإشارات”. الإشارة لم تختفِ، لكنها فقدت معناها واتجاهها.

يشبه الأمر شخصًا يجمع دخله ومصروفاته في رقم واحد، ثم يحاول اتخاذ قرار مالي بناءً على هذا الرقم فقط. قد يكون الرقم صفرًا، لكن هذا لا يخبره بشيء حقيقي عن وضعه المالي.

لماذا كانت مكافأة “قلة الخطوات” خطأ؟

لأن عدد خطوات الاستدلال ليس مقياسًا لجودته. في السياق القانوني:

- قاضٍ قد يختصر

- آخر قد يفصّل

- وكلاهما قد يكون صحيحًا

حين جعلنا قلة الخطوات هدفًا مستقلًا، لم نكافئ التفكير، بل كافأنا تجاوزه. كان الحل الأفضل هو مكافأة جودة الاستدلال (الاتساق المنطقي، الاستناد إلى المادة) بدلًا من طوله.

من استدلال كنص إلى استدلال كبنية

تقييم جودة الاستدلال كنص غير منظم مهمة شبه مستحيلة. الحل الذي اتجهنا إليه كان:

- تفكيك الاستدلال إلى بنية منطقية

- يمكن التحقق من اتساقها

مثل:

- Claims (الادعاءات)

- Rules (القواعد)

- Application (التطبيق)

- Verdict (الحكم)

الهدف لم يكن محاكاة المحكمة حرفيًا، بل فرض حد أدنى من المنطق القابل للفحص.

“لا قرار بلا مادة”

اخترنا أيضًا هدفًا سلوكيًا مرحليًا: ألا يصدر النموذج حكمًا دون الاستناد إلى مادة نظامية. حتى لو كانت المادة غير دقيقة.

هذا ليس تدريبًا على الصحة القانونية، بل على سلوك قابل للتتبع والمساءلة.

ما الذي نتعلمه من كل ذلك؟

الورقة تقدم آلية تقنية لتحسين إشارة التعلم في تعدد المكافآت. لكن التجربة تكشف درسًا أعمق:

النماذج لا تتعلم ما نريده، بل تتعلم ما نكافئه.

وحين نختزل السلوك في رقم واحد، نفقد ما لا يُقاس بالرقم:

- المنطق

- الاتساق

- المسؤولية

الخلاصة

النتيجة الصحيحة لا تعني تعلّمًا صحيحًا.

وإذا أردنا نماذج تفكّر، فعلينا أن نصمّم إشارات تعلم لا تكافئ الوصول فقط، بل الطريقة أيضًا.

المراجع

[1] Liu, S. Y., Dong, X., Lu, X., Diao, S., Belcak, P., Liu, M., Chen, M. H., Yin, H., Wang, Y. C. F., Cheng, K. T., Choi, Y., Kautz, J., & Molchanov, P. (2026). GDPO: Group reward-Decoupled Normalization Policy Optimization for Multi-reward RL Optimization. arXiv preprint arXiv:2601.05242. https://arxiv.org/abs/2601.05242[1] Liu, S. Y., Dong, X., Lu, X., Diao, S., Belcak, P., Liu, M., Chen, M. H., Yin, H., Wang, Y. C. F., Cheng, K. T., Choi, Y., Kautz, J., & Molchanov, P. (2026). GDPO: Group reward-Decoupled Normalization Policy Optimization for Multi-reward RL Optimization. arXiv preprint arXiv:2601.05242. https://arxiv.org/abs/2601.05242